und da haben wir dann auch die neuen 5000er rtx gpus von nvidia,

bei uns wird es dann 2329€ für die 5090 sein, 1169€ für die 5080, 879€ für die 5070ti und 649€ für die 5070.

bei 0:11 gibt es neues material zu doom: the dark ages, welches wie indy am pc mit path-tracing daherkommt.

mal schauen was die neutralen techseiten/youtuber so in den kommenden wochen über die karten zu berichten haben.

bei uns wird es dann 2329€ für die 5090 sein, 1169€ für die 5080, 879€ für die 5070ti und 649€ für die 5070.

NVIDIA DLSS 4 Introduces Multi Frame Generation & Enhancements For All DLSS Technologies

75 DLSS Multi Frame Generation games and apps available on day 0; graphics industry’s first, real-time transformer model enhances image quality for DLSS Ray Reconstruction, Super Resolution, and DLAA.

www.nvidia.com

DLSS Multi Frame Generation generates up to three additional frames per traditionally rendered frame, working in unison with the complete suite of DLSS technologies to multiply frame rates by up to 8X over traditional brute-force rendering. This massive performance improvement on GeForce RTX 5090 graphics cards unlocks stunning 4K 240 FPS fully ray-traced gaming.

DLSS 4 also introduces the biggest upgrade to its AI models since the release of DLSS 2.0 in 2020.

DLSS Ray Reconstruction, DLSS Super Resolution, and DLAA will now be powered by the graphics industry's first real-time application of 'transformers', the same advanced architecture powering frontier AI models like ChatGPT, Flux, and Gemini. DLSS transformer models improve image quality with improved temporal stability, less ghosting, and higher detail in motion.

75 DLSS games and apps featuring Frame Generation can be upgraded to Multi Frame Generation on GeForce RTX 50 Series GPUs.

For those same games, Frame Generation gets an upgrade for GeForce RTX 50 Series and GeForce 40 Series GPUs, boosting performance while reducing VRAM usage.

And on all GeForce RTX GPUs, DLSS games with Ray Reconstruction, Super Resolution, and DLAA can be upgraded to the new DLSS transformer model.

For many games that haven't updated yet to the latest DLSS models and features, NVIDIA app will enable support through a new DLSS Override feature. Alongside the launch of our GeForce RTX 50 Series GPUs, after installation of a new GeForce Game Ready Driver and the latest NVIDIA app update, the following DLSS override options will be available in the Graphics > Program Settings screen, under "Driver Settings" for each supported title.

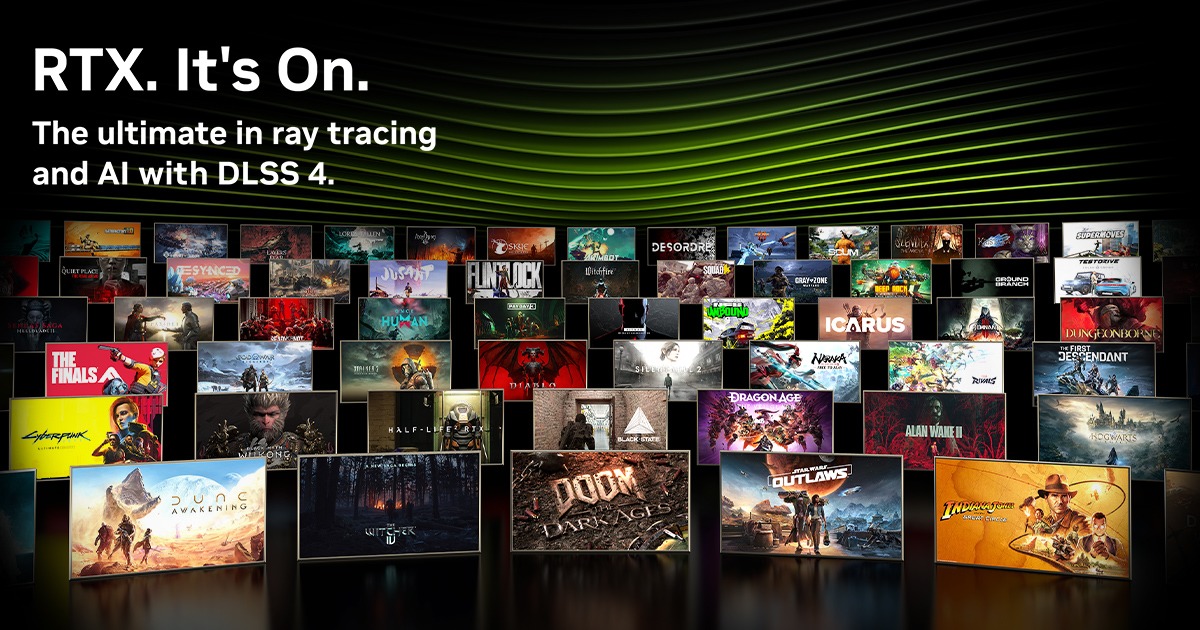

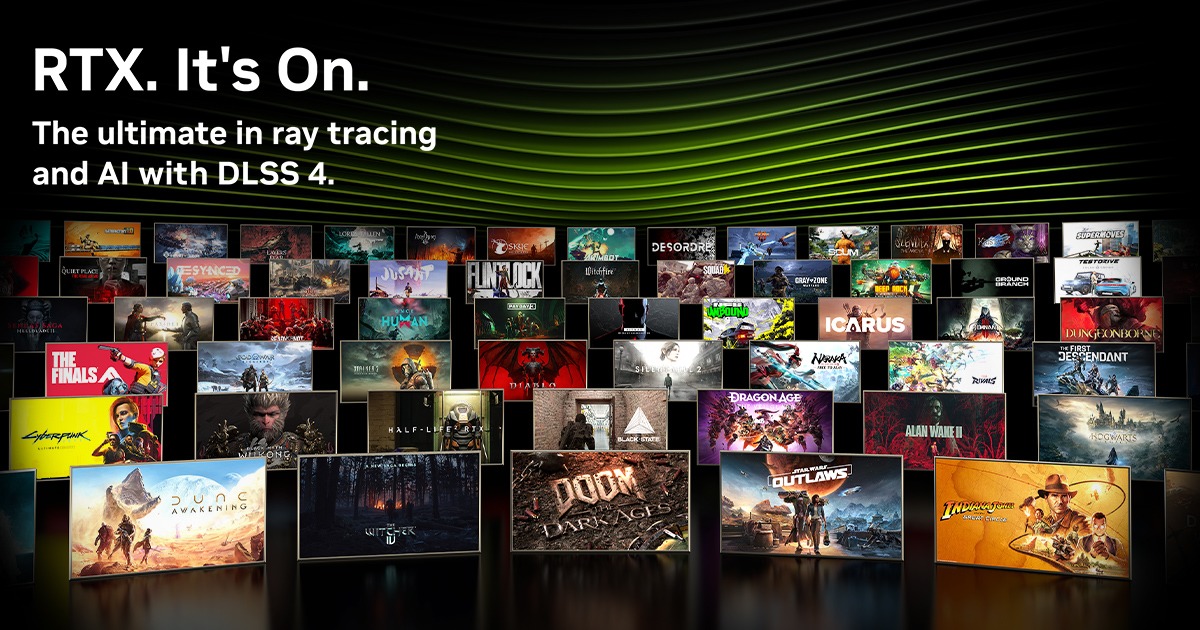

DLSS Multi Frame Generation & New RTX Technologies Coming To Black State, DOOM: The Dark Ages, Dune: Awakening, and More. 75 Games and Apps At Launch & More On The Way

Multiply performance by up to 8X and experience new cutting-edge NVIDIA RTX ray tracing and AI technologies in Alan Wake 2, Black Myth: Wukong, Marvel Rivals, NARAKA: BLADEPOINT, and many other titles.

www.nvidia.com

bei 0:11 gibt es neues material zu doom: the dark ages, welches wie indy am pc mit path-tracing daherkommt.

mal schauen was die neutralen techseiten/youtuber so in den kommenden wochen über die karten zu berichten haben.

Zuletzt bearbeitet: